Le terme « LLM » circule abondamment dans les échanges autour de l’intelligence artificielle, mais il désigne rarement la même chose d’un contexte à l’autre. L’apparition de ChatGPT a multiplié les interprétations et les détournements, au point que certaines utilisations en entreprise et dans l’éducation adoptent des définitions internes, parfois éloignées de l’origine technique.

Des confusions s’installent, alimentées par la rapidité des évolutions et l’absence de consensus sur les terminologies. Entre usages spécialisés et appropriation grand public, le sens d’une abréviation varie au gré des interlocuteurs et des besoins.

llm, gpt, nlp… décryptage des abréviations qui font l’IA

L’univers de l’intelligence artificielle déborde d’acronymes qui, derrière leur apparente simplicité, recouvrent des avancées techniques majeures. LLM n’est pas un simple sigle : il désigne un large language model, autrement dit un modèle linguistique d’une ampleur inédite, entraîné à comprendre, générer et manipuler des textes avec une aisance déconcertante. Pour atteindre cette performance, ces modèles s’appuient sur des architectures complexes nourries par des montagnes de données textuelles piochées sur Internet, dans des ouvrages ou des bases de savoirs. Aujourd’hui, les LLM forment le socle des agents conversationnels les plus avancés, à commencer par ChatGPT, l’assistant développé par OpenAI.

Une clarification s’impose toutefois : GPT n’est pas équivalent à LLM, mais représente une famille de modèles au sein de cette catégorie. Plus précisément, GPT signifie generative pre-trained transformer, soit un modèle génératif pré-entraîné selon une approche spécifique, reposant sur le deep learning et la mécanique de l’auto-attention. Cette dernière permet au système de saisir les relations entre mots dans une séquence de jetons (ou tokens), offrant une compréhension du contexte et une capacité de génération de texte bien supérieure à celle des modèles antérieurs.

L’acronyme NLP, pour natural language processing, traitement du langage naturel en français, revient lui aussi fréquemment. Cette discipline englobe l’ensemble des techniques donnant aux machines la possibilité de comprendre, d’analyser et de produire du texte humain. La nuance est d’échelle : le NLP rassemble tous les outils, du simple correcteur aux plus puissants LLM, tandis que GPT incarne le fleuron de la génération automatique de texte par apprentissage profond.

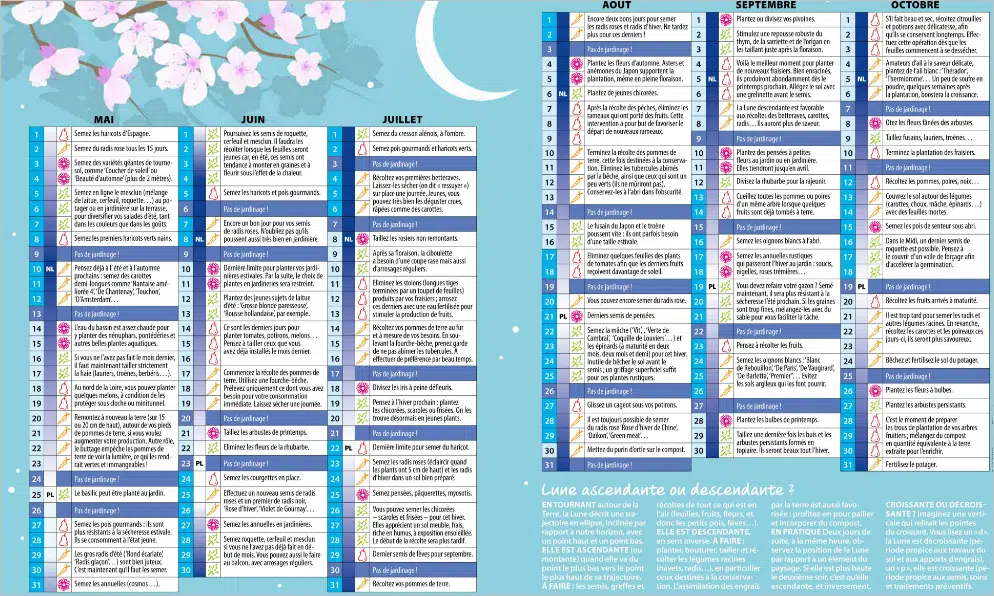

Pour clarifier ces sigles et faciliter la navigation dans ce vocabulaire foisonnant, voici un panorama des principales abréviations :

- LLM : modèle de langage de grande taille (large language model)

- GPT : modèle génératif pré-entraîné (generative pre-trained transformer)

- NLP : traitement automatique du langage naturel (natural language processing)

Cette diversité terminologique reflète la vitesse à laquelle évolue le secteur : chaque abréviation condense un pan du dialogue entre humains et machines, et redéfinit notre rapport au langage.

À quoi sert un large language model dans le quotidien, du chat à l’entreprise ?

L’impact d’un large language model excède largement le cadre des conversations avec un chatbot. Si beaucoup se limitent à l’image d’un assistant virtuel générant des réponses en temps réel, la réalité s’avère autrement plus riche. Dès qu’il s’agit de manipuler du texte ou d’exploiter la masse de données écrites, ces modèles deviennent incontournables, transformant la manière dont informations et décisions circulent.

Prenez le service client : un LLM gère des dizaines de milliers de requêtes, rédige instantanément des réponses sur mesure, oriente les demandes urgentes. Les tâches répétitives sont confiées à la machine, libérant les agents humains pour les situations complexes. Les flux de travail y gagnent : tri automatique des emails, rédaction assistée de contrats, analyse de sentiment sur les réseaux sociaux, rien n’échappe à leur capacité d’automatisation.

Voici quelques usages concrets qui illustrent cette diversification :

- Assistant virtuel : échanges naturels, organisation d’agenda, prise de rendez-vous.

- Traduction automatique : adaptation multilingue de contenus en temps réel.

- Analyse de sentiment : repérage des tendances et évaluation de la satisfaction des utilisateurs.

- Développeur augmenté : génération de code, rédaction automatisée de la documentation technique.

Dans l’entreprise, le traitement automatique du langage devient un atout stratégique. Extraire des points clés de rapports volumineux, résumer automatiquement des documents, générer des synthèses sur mesure : autant de tâches désormais accélérées par un LLM. L’assistant vocal d’aujourd’hui ne se contente plus d’exécuter des ordres ; il s’adapte, comprend le contexte, anticipe les besoins. À mesure que ces modèles gagnent en puissance, leur capacité à structurer, produire et transformer des quantités massives de texte redessine la cartographie des métiers.

ChatGPT en action : comment les modèles de langage transforment l’apprentissage et le travail

Avec l’arrivée de ChatGPT et consorts, la formation et les environnements professionnels prennent un virage décisif. Fini le temps où l’intelligence artificielle se limitait à répondre à des commandes : ces modèles de langage révolutionnent la façon d’apprendre, de transmettre et de collaborer.

À l’école comme à l’université, les enseignants s’approprient ces outils pour générer des exercices sur mesure, préparer des synthèses adaptées au niveau de chaque élève, ou encore automatiser la correction. Le texte généré devient un levier : matière à reformuler, à débattre, à approfondir. L’enseignant ajuste son accompagnement, l’élève gagne en autonomie, et chacun réinvente son rapport au savoir. Les établissements d’enseignement s’interrogent sur les nouveaux équilibres à trouver : comment tirer parti de l’automatisation, tout en luttant contre la tentation du plagiat ?

Côté entreprise, le rythme s’accélère : rédaction d’emails, synthèse de rapports, génération automatique de comptes rendus, la routine se digitalise. Dans la santé, les modèles de langage assistent le diagnostic, extraient l’essentiel des dossiers médicaux, rédigent des comptes rendus. Les services clients s’appuient sur ChatGPT pour absorber le volume tout en personnalisant la relation.

Des groupes majeurs, tels que Microsoft avec Copilot ou OpenAI avec GPT Turbo, intègrent ces solutions pour fluidifier le traitement documentaire, la veille stratégique ou la traduction. Ici, l’outil ne remplace pas l’humain : il agit en partenaire, assistant, multiplicateur d’efficacité. La question de la taille du modèle, du choix des données d’entraînement, de la pertinence du texte généré, reste centrale pour garantir la fiabilité et la pertinence des résultats.

Envie d’explorer plus loin ? Ressources et pistes pour s’initier aux usages des LLM

L’intérêt envers les modèles de langage n’a jamais été aussi fort. Chercheurs, développeurs, étudiants ou professionnels : chacun cherche à comprendre, tester et adapter ces LLM open source ou propriétaires à ses besoins. Plusieurs chemins existent pour s’initier et jauger le potentiel d’un large language model.

Les plateformes comme Azure OpenAI offrent la possibilité d’explorer, personnaliser et déployer des modèles de langage à grande échelle, tout en gardant la maîtrise sur la confidentialité et la sécurité des données. D’autres préfèrent les solutions open source pour ajuster la scalabilité et optimiser les ressources : Llama, Mistral ou Falcon en sont des exemples phares. Le fine-tuning (ajustement fin) ou le RLHF (apprentissage par retour humain) deviennent des leviers puissants pour adapter un modèle à des cas d’usage très ciblés, qu’il s’agisse de service client ou de veille documentaire.

Pour ceux qui souhaitent aller plus loin, plusieurs critères permettent d’évaluer les performances des modèles de langage :

- La perplexité, qui mesure la capacité du modèle à prédire le mot suivant dans une séquence

- Le score BLEU, servant à juger la qualité d’une traduction automatique

- Le score F1, qui combine précision et exhaustivité dans l’évaluation des réponses

Chaque test, chaque outil, chaque corpus de données éclaire un aspect particulier de cette intelligence artificielle générative. Mais ces expérimentations soulèvent aussi des questions : gestion des biais, respect du droit d’auteur, contrôle des hallucinations, cohérence et pertinence des réponses. La communauté, toujours plus active, échange méthodes, benchmarks et tutoriels, nourrissant un mouvement de partage et de critique constructive. Pour qui veut s’initier, comprendre ou auditer l’usage du langage naturel et de ses modèles, la porte reste ouverte, à condition d’avancer avec prudence et curiosité.

La course à la compréhension des LLM ne fait que commencer : demain, qui sait quels nouveaux usages viendront bousculer notre rapport au texte ?